Prompt Engineering – So bedienst du KI richtig (2026)

Vorab: Die wichtigsten Definitionen

Prompt Design

Prompt Design beschreibt die Technik, mit der du mit natürlicher Sprache ein Sprachmodell bedienen kannst.

Prompt Engineering

Prompt Engineering erweitert das reine Prompt Design und nutzt strukturierte und deklarative Module, damit Prompts in Testumgebungen iterativ optimiert werden können.

Context Engineering

Context Engineering beschreibt den Umgang mit und das Organisieren des Prompts zusammen mit individuellem Kontext, der von externen Quellen bezogen wird.

In diesem Artikel werden wir uns diese drei Techniken genauer anschauen. Du wirst lernen, wie du eine solide Grundstruktur für Prompts erstellst. Außerdem erfährst du, welche fortgeschrittenen Techniken es gibt, und erhältst einen Überblick über professionelles Prompt- und Context Engineering.

1. Was ist ein Prompt?

Ein Prompt ist zunächst einmal ein Text in natürlicher Sprache, den du einem KI-Modell bereitstellst, bevor dieses einen Output generiert. Der Prompt kann dabei aus reinem Text, Bildern, Audio, PDFs, Excel-Tabellen oder anderen Datentypen bestehen.

Der Prompt ist eine Sequenz aus "Prefix-Tokens", die das Sprachmodell in eine bestimmte Richtung seiner Trainingsdaten leitet. Ein einfaches Beispiel könnte sein:

Geben wir den selben Prompt an ein anderes Modell, z.B. GPT-4.5, dann erhalten wir eine andere Antwort:

Das Beispiel zeigt dir zum einen, dass die GPT-Modelle mit der Zeit eloquenter geworden sind. Zum anderen erkennst du aber auch, dass GPT-4.5 nicht nur den Satz vervollständigt, sondern zudem auch noch weitere Hilfe anbietet. Der Grund hierfür ist ein versteckter Prompt, den OpenAI in das Modell integriert hat.

Hidden Prompts (System Prompts)

Ohne dass du es mitbekommst, verwenden moderne AI Chatbots, wie z.B. ChatGPT, bei jeder Eingabe einen versteckten System-Prompt. Dieser Prompt wird bei jeder Eingabe ausgeführt und von den Modell-Entwicklern definiert, damit das Modell z.B. eine bestimmte Tonalität verwendet.

System Prompts können dafür genutzt werden, dem LLM allgemeine Rahmenbedingungen mitzugeben. Z.B. verwenden Tools wie v0 oder Replit ausführliche System Prompts, die das Modell auf das Erstellen von Programmiercode trimmen.

System Prompts können allerdings auch für Zensuren verwendet werden. Man geht z.B. davon aus, dass DeepSeekAI per System Prompt ihre Modelle dazu anweist, dunkle Fakten aus der chinesischen Geschichte zu verschleiern. Ebenso befahl Elon Musk dem Grok-3 Modell, dass weder er noch Donald Trump als Verbreiter von Misinformationen genannt werden sollten.

System Prompts werden also von den Modell-Entwicklern bereitgestellt, um das Modell in eine bestimmte Richtung zu trimmen. Über Jailbreaking-Techniken lassen sich diese Beschränkungen umgehen, du solltest dir aber bewusst sein, dass sich durch System-Prompts die Modelle verschiedener Entwickler auch unterschiedlich verhalten. Falls du dir einen Eindruck von verschiedenen System-Prompts machen möchtest, findest du hier eine Liste mit potenziellen System-Prompts von z.B. Cursor, Manus oder v0. Seit Kurzem veröffentlicht außerdem Anthropic zu jedem Modell den dazugehörigen System-Prompt auf ihrer Website.

User Prompts

Als User Prompts beschreibt man den Prompt-Inhalt, der vom User bereitgestellt wird. User Prompts bestehen zunächst einmal aus dem reinen Text-Prompt, können aber auch durch einen sogenannten Kontext mit anderen Modalitäten erweitert werden.

User Prompts werden durch ein Token-Fenster limitiert. Dieses Fenster gibt an, wie viele Tokens (Wörter) das Modell maximal verarbeiten kann. Bei GPT-4o beträgt das Input-Token-Fenster zum Beispiel 128.000 Tokens, was knapp 96.000 Wörtern (oder den ersten 12 Kapiteln von Herr der Ringe) entspricht.

Wenn wir nun vom Prompt Engineering oder Prompt Design sprechen, dann meinen wir damit die Technik, mit der du deinen User Prompt am besten formulierst.

2. Prompt Design - So solltest du deine Prompts aufbauen

Beim Prompt Design geht es darum, den richtigen Kontext für das Modell zu setzen, damit wir den bestmöglichen Output erhalten. Prompt Design lässt sich durchaus als Kunst bezeichnen, da es unendlich viele Möglichkeiten gibt, einen Prompt zu formulieren. Dennoch hat sich herausgestellt, dass manche Prompts in Benchmarks besser abschneiden als andere.

Prinzipiell helfen dir diese Punkte dabei, deinen Prompt-Output zu verbessern:

- definiere ein klares Ziel für deinen Prompt

- teile dem Modell so viele relevante Informationen wie möglich mit

- verwende Markdown oder XML-Tags, um deinen Prompt zu formatieren

- setze dem Modell Grenzen, indem du die Eigenschaften deines Outputs beschreibst

- verwende die Tonalität, die du auch im Output erwartest

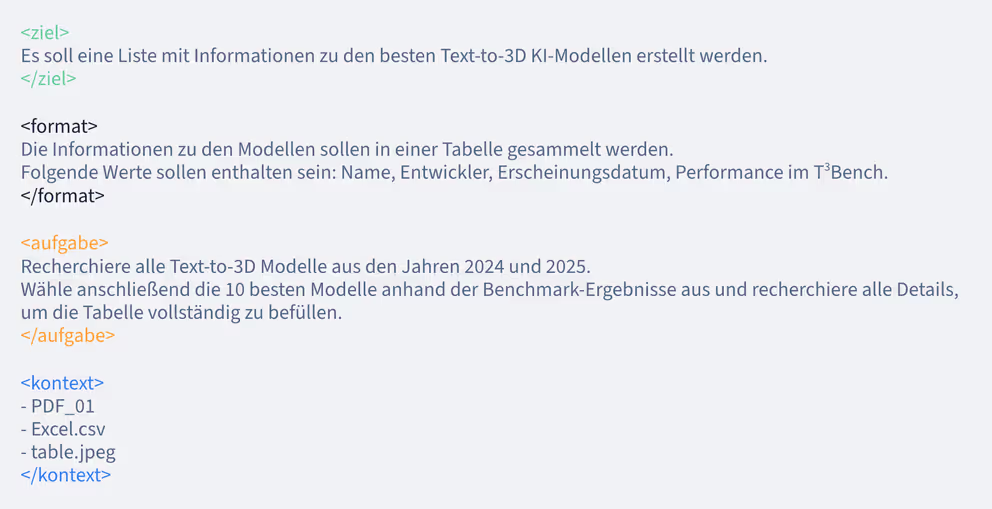

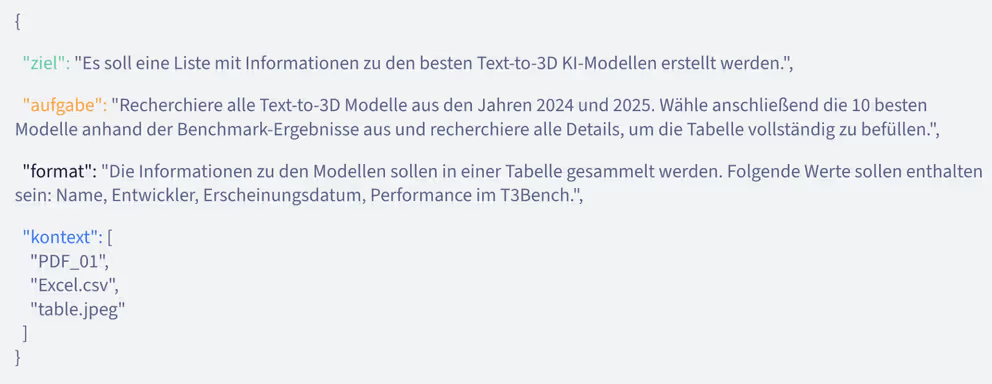

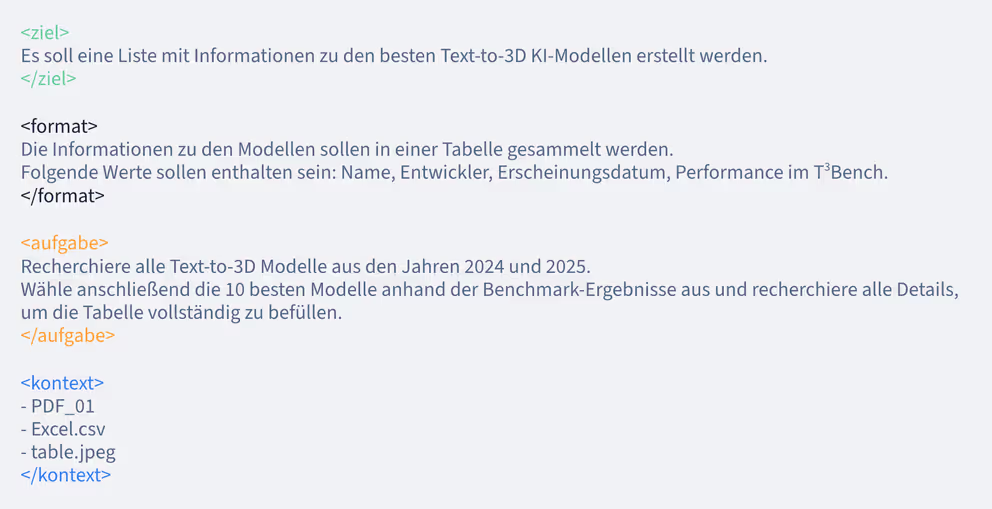

Aufbau eines effektiven Prompts

Ein bewährter Aufbau eines Prompts sieht wie folgt aus:

Du erkennst eine klare Struktur, die durch XML-ähnliche Tags um die Hauptsektionen Ziel, Format, Aufgabe und Kontext an das Modell signalisiert wird.

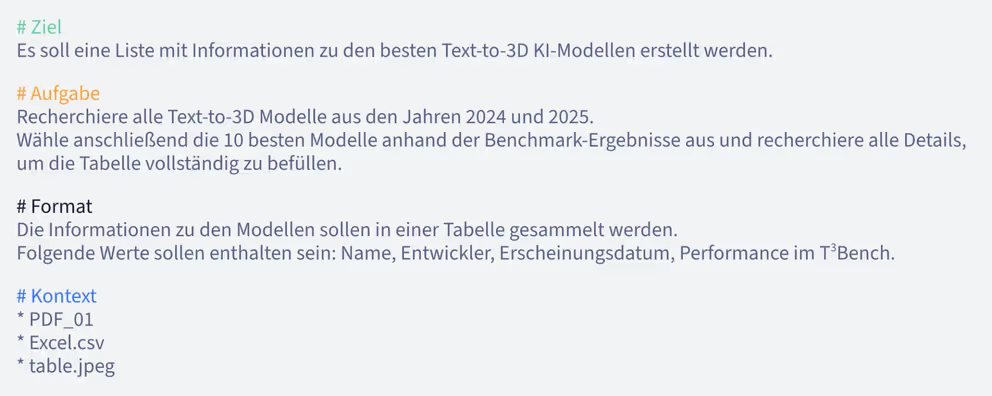

Prompt Design in verschiedenen Formaten

Eine Studie aus dem Jahr 2024 hat gezeigt, dass der Output durch das Format des Prompts stark beeinflusst werden kann.

Zwar konnte kein universelles Format für die besten Outputs gefunden werden, die Ergebnisse zeigen allerdings, dass es sich lohnen kann, mit verschiedenen Formaten zu experimentieren.

Neben dem Prompting im reinen Textformat setzen sich aktuell vor allem Prompts im Markdown, JSON und XML-Format durch.

Prompting im Markdown-Format

Markdown ist ein einfaches Format, um Texte zu strukturieren. Über Rauten (#) kannst du Überschriften erstellen und mit Sternchen (*) fette oder kursive Schrift erstellen. Auch Stichpunkte und Listen können einfach über Nummerierung oder Bindestriche erstellt werden.

Prompting im JSON-Format

JSON ist ein sehr strukturiertes Format, das in vielen Programmiersprachen eingesetzt wird. Es ist besonders gut für die Verarbeitung von Daten geeignet.

Prompting im XML-Format

XML (Extensible Markup Language) wird häufig für die Verarbeitung von Daten in verschiedenen Programmiersprachen eingesetzt. Prompts können in XML strukturiert werden, um den Input hierarchisch darzustellen.

Wenn du diese Prompt Design Techniken anwendest, dann kannst du deinen Output im Vergleich zu simplen Prompts bereits deutlich verbessern. Lass uns im nächsten Abschnitt nun fortgeschrittene Prompt Engineering Techniken kennenlernen.

3. Prompt Engineering - Fortgeschrittene Techniken zur Prompt Optimierung

Es gibt verschiedene Definitionen, die Prompt Engineering von Prompt Design unterscheiden. Manche Quellen verwenden Prompt Engineering bereits für das reine strukturelle Formatieren von Prompts, andere wiederum sehen es als letzte Stufe des Finetuning Prozesses beim Training eines Modells.

Bei Byte.de verwenden wir Prompt Engineering als Überbegriff für fortgeschrittene Techniken, die bewusst erprobte Strategien zum Verbessern der Outputs von Sprachmodellen verwenden.

Die aktuell wichtigsten Techniken für Prompt Engineering findest du im Folgenden zusammengefasst:

Shot-Prompting: Beispiel-Output vorgeben

Shot Prompting beschreibt Methoden, bei denen eine bestimmte Anzahl an Beispiel-Outputs vorgegeben wird, an denen sich das Sprachmodell orientieren soll.

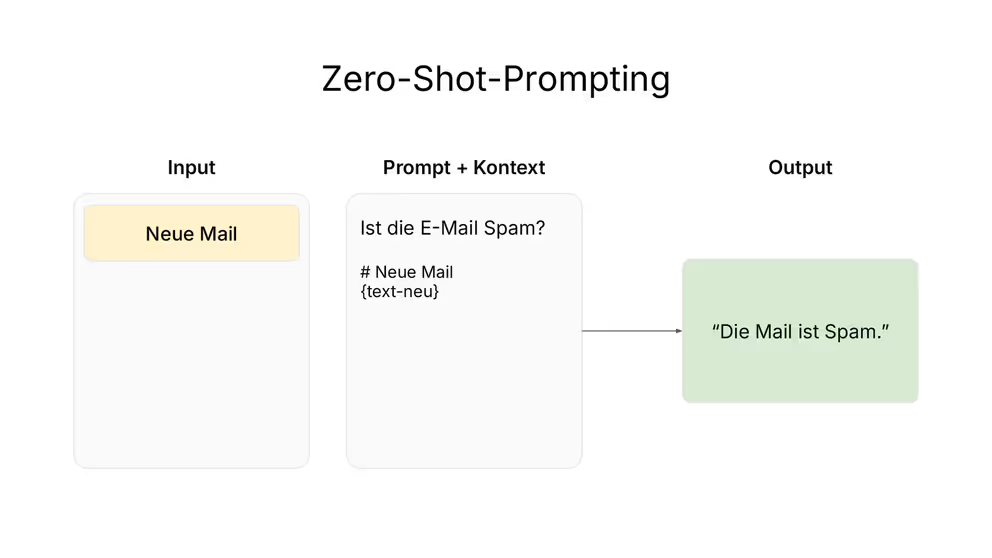

Zero-Shot Prompting: Prompt ohne Vorgabe

Beim Zero-Shot Prompting gibt man dem Modell eine klare Anweisung, aber ohne konkrete Beispiele oder Musterlösungen bereitzustellen. Das Modell greift auf die Trainingsdaten zurück und generiert einen Output, der sich an den Trainingsdaten orientiert. Im Beispiel würde ein Modell, das E-Mails als Spam oder Nicht-Spam klassifizieren soll, zum Beispiel einen vollständigen Satz ausgeben.

Zero-Shot Prompting eignet sich besonders für einfache Wissensabfragen oder Aufgaben, die allgemein bekannt und somit gut in den Trainingsdaten repräsentiert sind.

Beispiel für einen Zero-Shot Prompt:

Ordne folgenden Satz einer Stimmung zu (positiv, neutral, negativ): "Ich bin heute sehr zufrieden mit dem Essen."

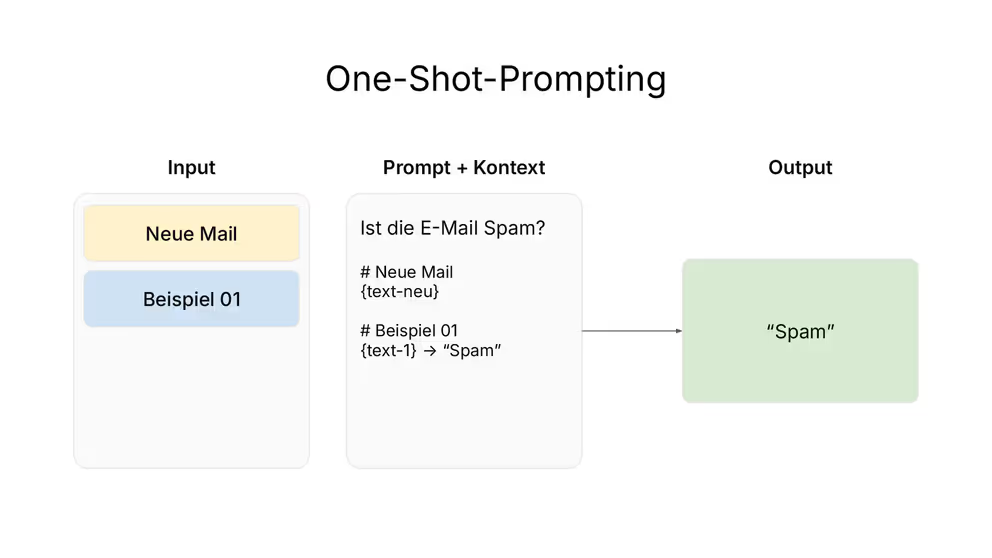

One-Shot Prompting: Einen Beispiel-Output vorgeben

Beim One-Shot Prompting wird genau ein Beispiel für den Output vorgegeben. Das Modell soll anhand dieses Beispiels erkennen, wie die Aufgabe zu erledigen ist. In unserem Beispiel würde das Modell als Output nur noch ein Wort für "Spam" ausgeben, wie wir es im Beispiel vorgegeben haben.

One-Shot Prompts eignen sich für Aufgaben, bei denen ein spezielles Antwortformat benötigt wird oder können iterativ verwendet werden, um die Qualität eines Outputs zu verbessern.

Beispiel für einen One-Shot Prompt:

1# Beispiel:

2> Frage: "Wie viel Uhr ist es?"

3> Antwort (humorvoll): "Zeit für einen Kaffee!"

4

5# Input:

6> Frage: "Wie ist das Wetter heute?"Das Modell würde bei diesem Prompt von einer pragmatischen Antwort abweichen und auch auf andere Fragen, wie z.B. "Wie ist das Wetter heute?" eine humorvolle Antwort generieren.

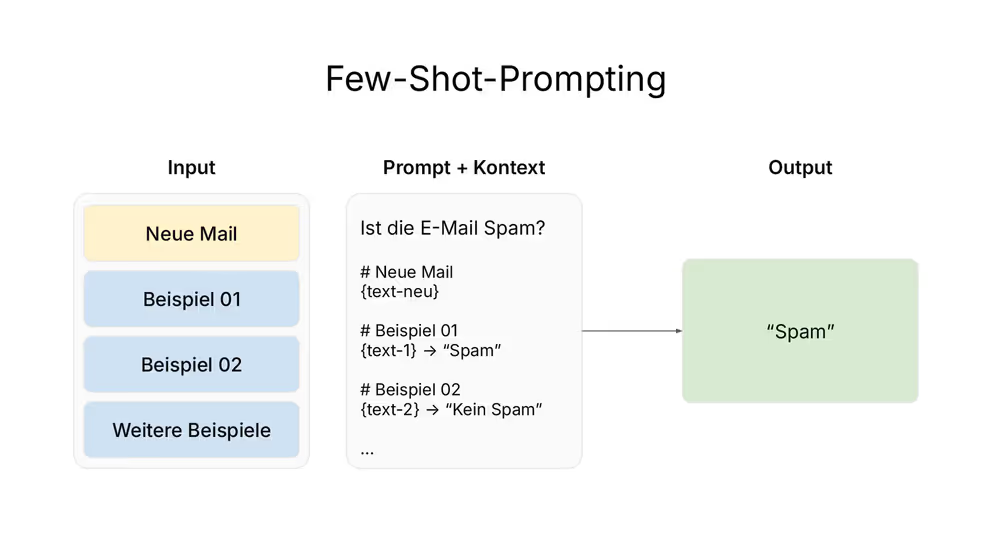

Few-Shot Prompting: Mehrere Musterlösungen vorgeben

Beim Few-Shot Prompting wird eine Anzahl > 1 von Beispiel-Outputs vorgegeben. Je mehr Beispiele vorgegeben werden, desto besser kann das Modell Muster erkennen und auf den Output anwenden. In unserem Beispiel könnten wir somit die Wahrscheinlichkeit erhöhen, dass unser Modell neue E-Mails auch im Fall von "Nicht-Spam" mit dem korrekten Format klassifizieren würde, da wir entsprechende Beispiele mit angehängt haben.

Meistens reicht es, wenn man 3-5 Beispiele vorgibt. Je nach Länge der Beispiele kann sonst ein langer Kontext entstehen, der das Modell verlangsamt und den Output teurer macht.

Beispiel für einen Few-Shot Prompt:

1# Beispiel 1:

2> Text: "Die App tut, was sie soll."

3> Stimmung: neutral

4

5# Beispiel 2:

6> Text: "Die App ist sehr schlecht und hat keine nützlichen Funktionen."

7> Stimmung: negativ

8

9# Beispiel 3:

10> Text: "Ich habe gute Erfahrungen mit der App gemacht und kann sie weiterempfehlen."

11> Stimmung: positiv

12

13# Input

14> Text: "Die App funktioniert großartig und bietet viele nützliche Funktionen."Few-Shot Prompting eignet sich besonders für Aufgaben, bei denen Mustererkennung oder das Einhalten eines bestimmten Formats erforderlich ist.

Prompt Chaining: Aufeinanderfolgende Prompts miteinander verknüpfen

Prompt Chaining beschreibt eine Technik, bei der man eine Haupt-Aufgabe in mehrere Unteraufgaben zerlegt und diese dem Modell als Schritt-für-Schritt-Anleitung übergibt.

Prompt Chaining eignet sich dementsprechend besonders gut für komplexe Aufgaben, die in Teilschritte zerlegt werden können, oder auf Workflows, die Zwischenergebnisse vorheriger Aufgaben benötigen.

Beispiel für Prompt Chaining:

11. Prompt:

2> Analysiere den Artikel von Finanzwissen.de und identifiziere alle Trends im Bereich der Robotik.

3

42. Prompt:

5> Erstelle eine Liste der 5 wichtigsten Trends anhand des Artikels

6

73. Prompt:

8> Liste anhand der 5 wichtigsten Trends Unternehmen auf, die von diesen Trends profitieren könnten.

9

104. Prompt:

11> Filtere alle Unternehmen heraus, die nicht börsengelistet sind.Chain of Thought Prompting: Denkprozess des Modells steuern

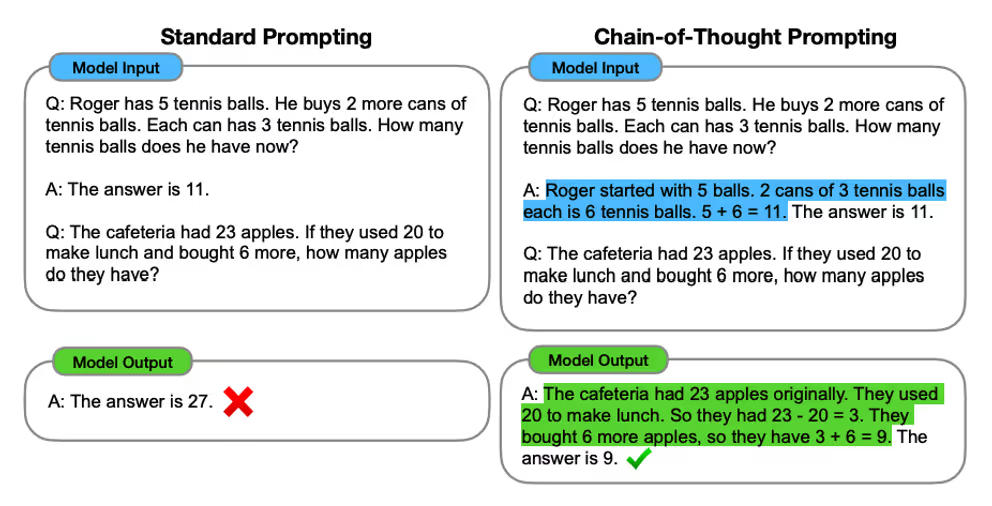

Chain-of-Thought beschreibt eine Technik, die durch Reasoning-Modelle wie DeepSeek-R1 oder OpenAI-o1 viel Zulauf erfahren hat.

Beim Chain-of-Thought Prompting fordert man das Modell dazu auf, einzelne "Denkprozess-Schritte" auszugeben. Diese Denkschritte, die häufig in über <think> Brackets angedeutet werden, werden anschließend als Input für den finalen Output verwendet.

Chain-of-Thought Prompting erhöht allgemein die Ergebnisse von Modellen in diversen Benchmarks. Besonders starke Unterschiede zeigen sich bei Logik-Rätseln sowie mathematischen Herausforderungen oder Planungsaufgaben.

Wenn du Reasoning-Modelle benutzt, wird eine Chain-of-Thought Logik bereits über den System-Prompt integriert. Verwendest du Non-Reasoning bzw. Foundation-Modelle, kannst du den Output des Modells über CoT jedoch noch einmal deutlich verbessern.

Beispiel für Chain-of-Thought Prompting:

1# Beispiel

2

3> Frage: Lisa hat zwei Brüder. Jeder Bruder hat zwei Schwestern. Wie viele Geschwister hat Lisa?

4> Antwort: <think> Lisa hat zwei Brüder. Jeder Bruder hat zwei Schwestern. Lisa ist von beiden Brüdern eine Schwester, also haben beide Brüder noch eine Schwester. Lisa hat also zwei Brüder und eine Schwester. Lisa hat also 3 Geschwister.</think> Lisa hat 3 Geschwister.

5

6# Input

7

8> Frage: Bjarne's Vater hat 2 Brüder. Jeder Bruder hat eine Schwester haben. Wie viele Tanten hat Bjarne?Beim Chain-of-Thought Prompting werden deutlich mehr Output-Tokens generiert als bei anderen Prompting-Techniken. Dies führt dazu, dass Reasoning-Modelle wie OpenAI-o3 mini oder Claude-3.7-Sonnet (thinking) sehr teuer und langsam sind. Wenn bei Reasoning-Modellen ein Attribut wie "low", "medium" oder "high" / "Pro" angegeben wird, bedeutet dies, dass mehr "Denkprozess-Tokens" generiert werden, was den Output grundsätzlich besser macht.

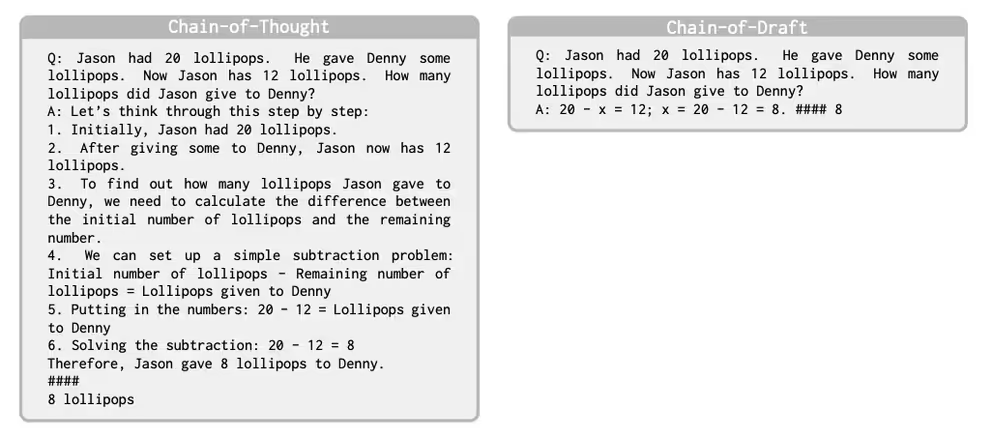

Chain of Draft: Günstiges Reasoning

Chain-of-Draft ist eine neuere Technik, die auf Chain-of-Thought basiert und dabei versucht, die Kosten für Reasoning-Modelle zu reduzieren. Dabei versucht man über Chain-of-Draft im <think> Zwischenschritt nur die relevanten Inhalte zu speichern, um Zwischen-Tokens zu sparen.

In ersten Studien konnte gezeigt werden, dass Chain-of-Draft bei einigen Aufgaben ähnliche Ergebnisse wie Chain-of-Thought erzielt, dabei aber signifikant günstigre ist. Allerdings ist die CoD-Prompting-Technik auf Few-Shot-Prompts angewiesen und eignet sich somit nicht für alle Aufgaben.

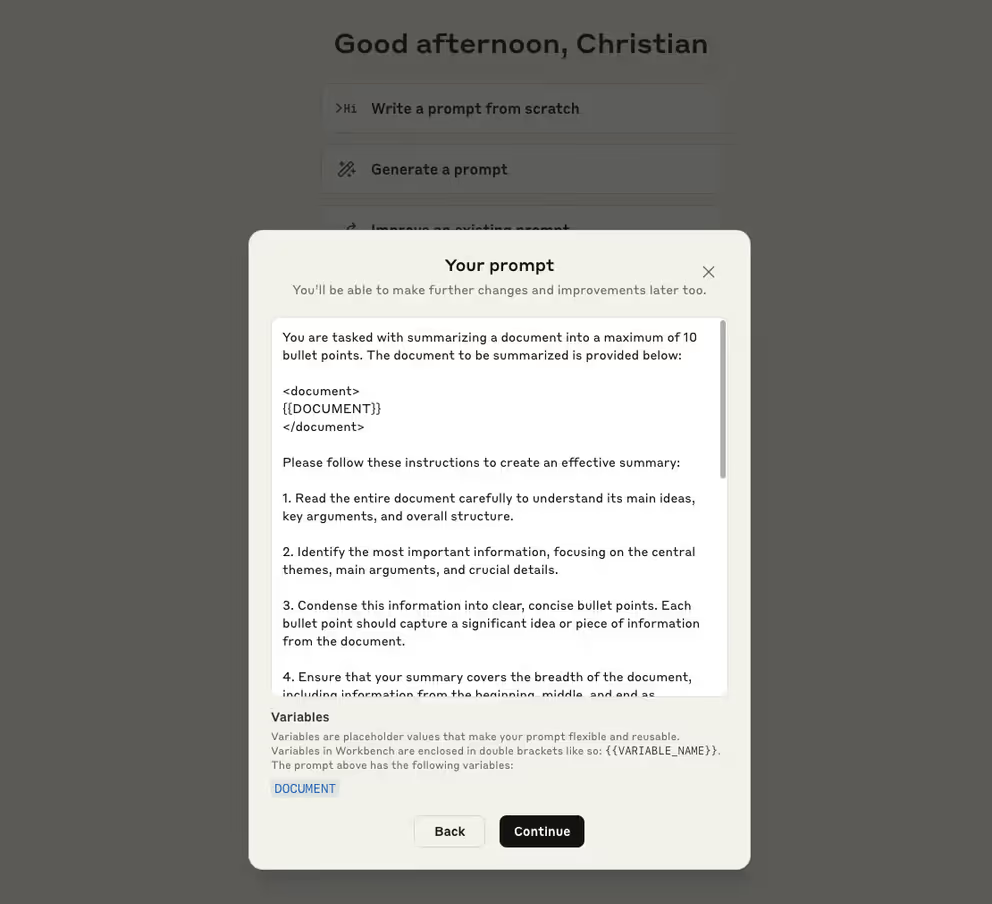

Meta-Prompting: KI-generierte Prompts

Meta-Prompting ist eine spannende Methode, bei der man ein Sprachmodell über einen "Meta-Prompt" beauftragt, selbst einen Prompt für eine bestimmte Aufgabe zu generieren. Grundsätzlich funktionieren Meta-Prompts so, dass man die Aufgaben- bzw. Fragestellung analysiert, Ziele identifiziert und anschließend Lösungsansätze und Aufgabenschritte in einem Prompt formuliert.

Meta-Prompting eignet sich besonders für Aufgaben, die von kleineren Modellen gelöst werden sollen. Den Meta-Prompt übergibt man an ein großes Reasoning-Modell, das dann den Prompt für die ausführenden kleineren Modelle erstellt.

Wenn du keinen Zugriff auf große Reasoning-Modelle hast, kannst du auch einen Prompt-Generator verwenden oder den Prompt-Optimizer in der Anthropic Konsole verwenden.

Prompt Injection: KI-Modelle jailbreaken

Unter dem Begriff "Prompt Injection" versteht man das Manipulieren von KI-Modellen durch Prompts. Über bestimmte Anweisungen ("Injection") im Prompt versucht man, das Verhalten des Modells so zu beeinflussen, dass ein Output generiert wird, der eigentlich nicht ausgegeben werden sollte.

Angreifer können versuchen, über Prompt Injection an sensible Informationen, wie z.B. geleakte API-Keys, zu gelangen. Ein populäres Beispiel ist auch die Angst, dass Sprachmodelle in der Lage sind, Bauanleitungen für Bio-Waffen o.Ä. zu erstellen. Modellentwickler versuchen über verschiedenste Sicherheitstechniken, dies zu unterbinden.

Da viele Trainingsdaten auf menschlicher Kommunikation basieren, können bei der Prompt Injection auch viele Strategien des Social Engineerings funktionieren.

Prompt Injection ist ein ernstzunehmender Problem für Firmen, die KI-Modelle bereitstellen. Der Cybersecurity-Dienstleister Lakera entwickelt Sicherheitsmaßnahmen, um Injection-Angriffe zu verhindern. Auf der Lakera Website kannst du über den "Gandalf" Chatbot versuchen, verschieden starke Sicherheitsmaßnahmen zu umgehen. Ein ziemlich unterhaltsamer Zeitvertreib, bei dem man gleichzeitig ein gutes Gefühl für Prompt Injection bekommt. Ich habe es beim ersten Anlauf bis Level 5 geschafft, kommst du noch weiter?

3. Best Practices und häufige Fehler beim Prompt Engineering

Wenn du es bis hierhin geschafft hast, dann hast du die Grundlagen und eine Menge an Techniken für das Prompt Engineering kennengelernt. Lass uns abschließend noch einmal die Best Practices zusammenfassen und häufige Fehlerquellen auflisten, die zu schlechteren Prompt Ergebnissen führen können.

Do's: Tipps für das Prompt Engineering

- Definiere ein konkretes Ziel

Versuche den Prompt so konkret wie möglich mit einem klaren Ziel zu formulieren. Vage Prompts, bei denen nicht klar ist, was für das Modell das Ziel sein soll, verschlechtern den Output enorm. - Kontext is King

Je mehr relevante Informationen du dem Modell mitteilst, desto genauer kann das Modell den Prompt verarbeiten. Beachte jedoch, dass bei der API-Nutzung mehr Kontext zu höheren Kosten führt. - Gib ein Output-Format vor

Egal ob Stichpunkte, Tabellen, Fließtext oder kurze Zusammenfassung. Gib dem Modell konkret vor, in welchem Format du den Output erwartest. - Struktur über Markdown oder XML

Klare Trennung von Prompt-Abschnitten hilft dir und dem Modell dabei, die Aufgabe besser zu verstehen. - Kein Prompt ist (sofort) perfekt

Häufig benötigt man mehrere Iterationen, um einen wirklich guten Prompt für eine komplexe Aufgabe zu finden. Verwende bei Bedarf die Few-Shots-Technik, um die Qualität des Outputs zu verbessern. - Lerne von guten Prompts

Versuche Prompts von professionellen Prompt Ingenieuren zu finden. Geleakte System Prompts können z.B. eine Quelle für interessanten Prompt-Ideen sein. - Kenne dein Modell

Unterschiedliche Modelle benötigen verschiedene Prompt-Techniken. Verwende Chain-of-Thought für Foundation-Modelle, aber halte Prompts für Reasoning-Modelle so konkret wie möglich.

Don'ts: Häufige Fehler beim Prompten

- Zu komplexe Aufgaben in einem Prompt

Rom wurde nicht an einem Tag gebaut. Stehst du vor einem komplexen Problem, unterteile dieses in Teilaufgaben, die zu einzeln promptest. Zu viele Teilaufgaben in einem Prompt führen zu schlechten Ergebnissen. - Wichtige Details auslassen

Das Gegenstück von "Zu viel" ist "zu wenig". Häufig hat man geistig einen riesigen Kontext, vergisst aber, Zusatzinformationen auch an das Modell zu übergeben. Prompt-Templates können dabei helfen, keine wichtigen Informationen auszulassen. - Unklare Formulierungen

Sind deine Prompts zu vage und unkonkret, ist es schwierig für das Modell, den korrekten semantischen Bereich zu finden. Versuche deinen Prompt so konkret wie möglich zu formulieren. - Format-Inkonsistenzen

Achte insbesondere beim Few-Shot-Prompting darauf, dass das Format deiner Beispiele korrekt ist. Hast du per Copy-Paste z.B. einen Syntax-Fehler in deinem JSON-Format, wird auch die KI diesen Fehler reproduzieren. - Ignorieren der KI-Grenzen

Künstliche Intelligenz kann bereits heute die durchschnittliche Intelligenz eines Menschen übertreffen, ist aber nicht allwissend. Letztenendes basieren LLMs auf dem menschlichen Wissen ihrer Trainingsdaten und können somit keine ungeklärten Probleme lösen.

Und ein letzter Tipp:

Bleib neugierig und geduldig beim Experimentieren mit deinen Prompts. Als Einsteiger ist man schnell frustriert, wenn die KI nicht die Ergebnisse liefert, die man erwartet. Doch genau darum geht es beim Prompt Engineering! Das Finetuning hilft dir dabei, Prompting-Techniken zu erlernen und Muster in der Ausgabe zu erkennen. Professionelle Prompt Ingenieure benötigen häufig unzählige Iterationen, bis sie einen finalen Prompt für die Produktionsumgebung finden. Lass dir Zeit und teste so viel wie nötig.

4. FAQ: Häufige Fragen zum Prompt Engineering

Was versteht man unter Prompt Engineering?

Prompt Engineering beschreibt Techniken, mit denen man versucht die Ausgabe von KI-Modellen durch formulierte Eingaben ("Prompts") zu optimieren. Prompt Engineering wird insbesondere von Firmen verwendet, um Prompts zu optimieren, die ständig in Produktionsprozessen verwendet werden.

Wie kann ich Prompt Engineering lernen?

Prompt Engineering lässt sich am besten lernen, indem man über ChatBots oder Playgrounds experimentiert. Auch über professionelle Prompts (z.B. geleakte System Prompts) lässt sich viel über das erfolgreiche Prompting lernen.

Was ist der Unterschied zwischen Prompt Engineering und Prompt Design?

Prompt Engineering bezieht sich eher auf die technische Optimierung und systematische Entwicklung von Prompts, wohingegen Prompt Design sich auf die kreative und sprachliche Gestaltung der Prompts konzentriert.

Wie formuliere ich gute Prompts?

Gute Prompts sind klar, präzise und enthalten idealerweise Ziel, Kontext, konkrete Aufgabenstellungen und ggf. gewünschte Ausgabeformate. Konkrete Techniken für das Prompt Engineering findest du in diesem Artikel.